Prompt Compression论文阅读

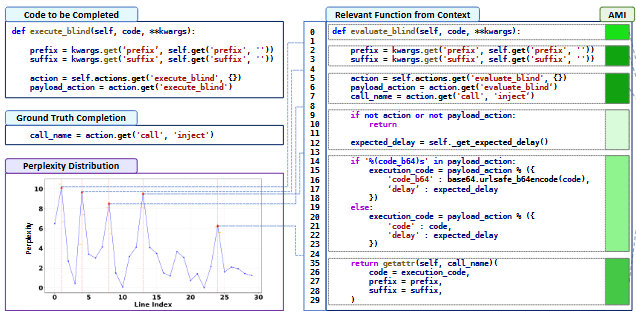

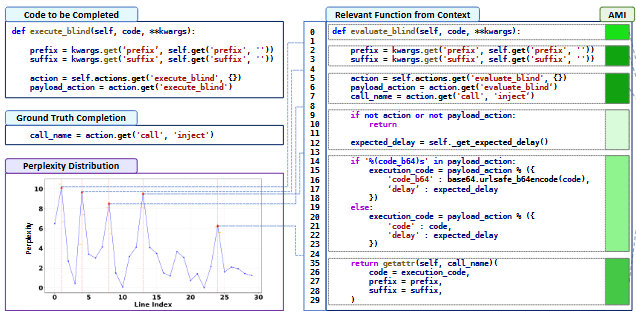

双压缩 LongCodeZip: Compress Long Context for Code Language Models 问题:虽然LLM很强大,但LLM压缩推理时候如果上下文过长,需要一定限制,不然导致信息丢失,性能下降。 传统的一些解决思路: LLMLingua:用小的transformor模型,对原始prompt 或上下文,语义保留的重…

1 篇文章